手話班

手話とは

手話は、ものごとの意味・内容を手指の動き、表情、動作などで具体的に表していく“視覚的な言語”です。そして、聴覚障害者のコミュニケーションの手段として、聴覚障害者が自立し社会参加をしていくうえで大きな役割を果たしています。

手話は、ものごとの意味・内容を手指の動き、表情、動作などで具体的に表していく“視覚的な言語”です。そして、聴覚障害者のコミュニケーションの手段として、聴覚障害者が自立し社会参加をしていくうえで大きな役割を果たしています。本研究室では健聴者と聴覚障害者のコミュニケーションを支援する目的で、コンピュータによる自動手話認識の研究を行っています。

背景と目的

人口の約5%

近年、わが国では高齢化が進み、難聴者の方は600万人(中等度以上(40dB以上)の聴覚障害者)を超えています。 難聴者の方のコミュニケーション手段に手話がありますが、健常者で手話を使える人が少ないため、難聴者の方が不便を強いられることがあります。自動翻訳システムの構築

そこで、手話班では手話の自動翻訳システムを作ることを大きな目標としています。手話の文法は手の動きだけでなく、表情も文法に含まれます。 動画像から画像処理を用いて手の動きや表情を認識できるよう研究を進めています。

研究内容

[1] 手話単語の認識

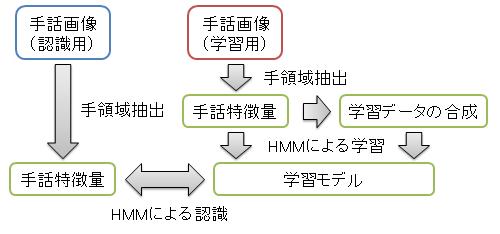

手話動画から画像処理により手の位置や形を抽出し隠れマルコフモデル(HMM)を用いて学習、認識を行います。 手話ではしばしば手同士もしくは手と顔の重複が起こり、手の位置や形の抽出が難しい場合があります。 その場合には、テンプレートマッチングや手の見えを学習した検出器を作成することで手の位置を推定します。 既存研究ではどの単語にも固定のモデルを使用していたため、認識率が高くありません。 そこで、現在は単語に適したモデルを自動で作成することで認識率を上げようとしています。 また、手話の学習を行う際に本来はたくさんのデータが必要となるのですが、少ないデータでも十分な学習ができるよう、 似た動きや手の形をしているデータから学習データを合成する研究も行っています。

手や顔の抽出・追跡

[2] 表情の認識

顔画像から特徴点を抽出し、ニューラルネットワークを用いて特徴点の変化から表情認識を行います。 現在の時点では、喜び、怒り、悲しみ、疑問、無表情といった5つの表情を認識することができました。 しかし実際の手話動画では手が顔の前で動く場合があり、顔の特徴点が取れない場合があります。 そのような場合でも表情を識別できるよう、システムを改善しています。

表情認識

手話班の研究紹介ポスター

メンバー

- POST D 松尾 直志 ( matsuo [at] @i.ci.ritsumei.ac.jp )

- M2 北村 卓之 ( kitamura [at] @i.ci.ritsumei.ac.jp )

- M2 森 昭太 ( mori [at] @i.ci.ritsumei.ac.jp )

- B4 入山 裕光( iriyama[at]@i.ci.ritsumei.ac.jp)